Datos Extremales (2025)

2025-02-18

Capítulo 1 La teoría asintótica clásica, las distribuciones extremales y sus dominios de atracción

Se dice que tenemos datos extremos cuando cada dato corresponde al máximo o mínimo de varios registros. Ejemplos de este tipo de datos son:

- La máxima altura semanal de la ola en una plataforma marina o portuaria \((m)\).

- La máxima velocidad de viento en determinada dirección a lo largo de un mes \((km/h)\).

- La temperatura ambiental mínima a lo largo de un día \((\dot{C})\).

- La temperatura ambiental mínima a lo largo de un día (\(\dot{C}\))

- La máxima velocidad de tráfico en un enlace de una red de datos de datos en una hora (\(Mb/s\)).

- El mayor registro en un conteo de Coliformes fecales sobre agua costeras al cabo de quince días.

Son un caso particular de evento raro o gran desviación respecto a la media. En resumen, en una gran variedad de dominios disciplinares suele ser de gran interés el trabajo con datos extremos, los que admiten diversos enfoques. Entre ellos, los propios al párrafo anterior (eventos raros, grandes desviaciones), que se verán en el curso. Sin embargo, el comienzo del curso se centra en la teoría más clásica de estadística de datos extremos, basada en el trabajo de Fréchet, Gumbel, Weibull, Fisher, Tippett, Gnedenko, entre otros.

Observación 1: Se recuerda que si \(X\) e \(Y\) son variables aleatorias independientes, cuyas distribuciones son, respectivamente, \(F\) y \(G\), entonces la variable

\[\begin{equation} \max \left( X,Y \right) \label{eq:1} \end{equation}\]

tiene por distribución la función \(H\) definida por

\[\begin{equation} H(t)= F(t)\; G(t) \label{eq:2} \end{equation}\]

Observación 2: En esta parte inicial del curso asumiremos que nuestros datos son \(iid\) (independientes e idénticamente distribuidos, son dos suposiciones juntas). Esta doble suposición suele NO ser realista en aplicaciones concretas (ninguna de sus dos componentes, incluso) pero para comenzar a entender la teoría clásica, la utilizaremos por un tiempo.

Observación 3: Resulta claramente de la Observación 1, que si tenemos datos \(X_1,...,X_n\) \(iid\) con distribución \(F\), entonces

\[\begin{equation} X_n^{\ast}= \max \left( X_1,...,X_n \right) \end{equation}\]

tiene distribución \(F_n^\ast\) dada por

\[\begin{equation} F_n^\ast (t) = F(t)^n \end{equation}\]

Si conocemos la distribución \(F\) conoceríamos la distribución \(F_n^\ast\), pero en algunos casos la lectura que queda registrada es la del dato máximo y no la de cada observación que dio lugar al mismo, por lo que a veces ni siquiera es viable estimar \(F\). Pero aún en los casos en que \(F\) es conocida o estimable, si \(n\) es grande, la fórmula de \(F_n^\ast\) puede resultar prácticamente inmanejable. En una línea de trabajo similar a la que aporta el Teorema Central del Límite en la estadística de valores medios, un teorema nos va a permitir aproximar \(F_n^\ast\) por distribuciones más sencillas. Este es el Teorema de Fischer-Tippet-Gnedenko (FTG) que presentaremos en breve.

Observación 4: Si \(X_1,...,X_n\;\) es \(iid\;\) y definimos \(\;Y_i = -X_i\;\) para todo valor de \(i\), entonces \(Y_1,...,Y_n\;\) es \(iid\;\) y además

\[\begin{equation} min(X_1,...,X_n) = - max(Y_1,...,Y_n) \end{equation}\]

la teoría asintótica de los mínimos de datos \(iid\) se reduce a la de los máximos, razón por la que nos concentramos aquí en estudiar el comportamiento asintótico de los máximos exclusivamente.

Definición 1: Las distribuciones extremales.

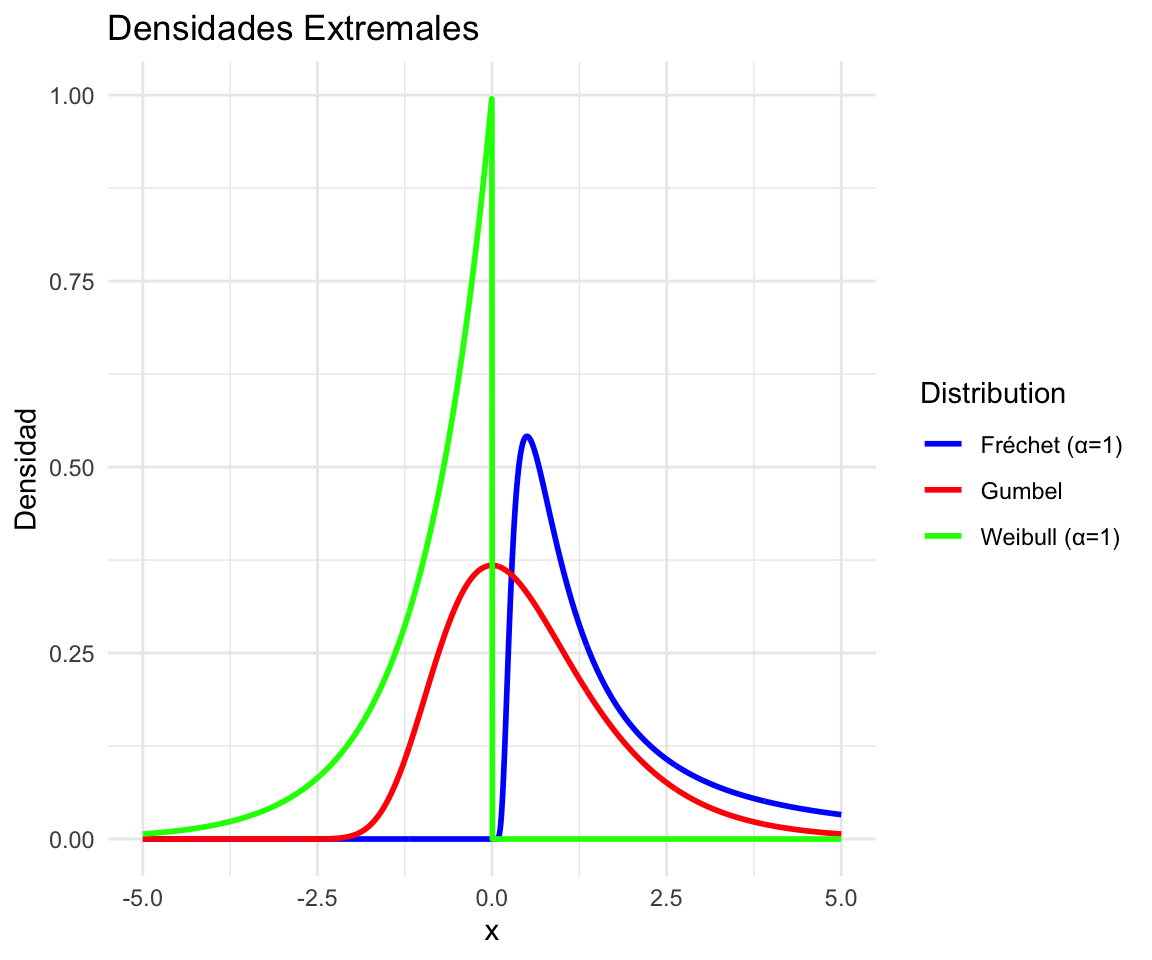

Las distribuciones extremales son tres: la distribución de Gumbel, la distribución de Weibull y la distribución de Fréchet. En su versión standard o típica se definen del modo siguiente.

Se dice que una variable tiene distribución de:

-Gumbel si su distribución es

\[\Lambda(x) = e^{\{-e^{-x}\}}\hspace{0.3cm}\text{ para todo }\: x \;\text{real}.\]

-Weibull de orden \(\alpha>0\) si su distribución es

\[\Psi_{\alpha}(x)=\begin{cases} e^{\left\{-(-x)^{\alpha} \right\}} & si\;x<0\\ 1 & \text{en otro caso} \end{cases}\]

-Fréchet de orden \(\alpha>0\) si su distribución es

\[ \Phi_{\alpha}(x)=\begin{cases} e^{\left\{ -x^{-\alpha}\right\}} & si\;x>0\\ 0 & \text{en otro caso} \end{cases} \] Nota: Como los máximos en general son valores grandes, importa particularmente observar el comportamiento de estas distribuciones para \(x\) tendiendo a infinito. El límite es \(1\) como en toda distribución. Pero VA MAS RAPIDO a 1 la Weibull, luego la Gumbel y luego la Fréchet. Esto es indicio que la Fréchet modela datos más extremos, máximos de datos de colas más pesadas que la Gumbel y ésta que la Weibull. Más adelante veremos esto más precisamente. En la Fréchet, la velocidad de convergencia a 1 crece al aumentar el orden. En cambio en la Weibull el orden afecta la velocidad con que va a 0 cuando \(x\) tiende a menos infinito, que crece cuanto mayor el orden. Esto quedará más claro con el Teorema 1 del curso. La visualización de las densidades de cada tipo quizás ayude a comprender mejor los pesos relativos de las colas.

A estas versiones standard se las puede extender agregando un parámetro de recentramiento \((\mu)\) y un parámetro de escala \((\beta)\).

Se dice que \(X\) tiene distribución:

Gumbel : \(\Lambda^{(\mu, \beta)}\) si \(\;X=\mu + \beta Y\;\), donde \(Y\) tiene distribución \(\Lambda\).

Weibull: \(\;\Psi^{(\mu, \beta)}\;\) si \(\;X=\mu + \beta Y\;\), donde \(Y\) tiene distribución \(\Psi_{\alpha}\).

Fréchet: \(\;\Phi^{(\mu, \beta)}\;\) si \(X=\mu + \beta Y\), donde \(Y\) tiene distribución \(\Phi_{\alpha}\).

En general, es en este sentido que diremos que una variable es Gumbel, Weibull o Fréchet (incluyendo recentramiento y reescalamiento), pero en cálculos donde los parámetros \(\mu\) y \(\beta\) no sean relevantes, por simplicidad, usaremos las versiones standard.

El siguiente teorema vincula las distribuciones extremales en sus formatos standard y resulta de gran utilidad práctica sobre todo al hacer tests de ajustes, etc.

Teorema 1 : Relaciones entre las versiones standard de las distribuciones extremales.

\(X\) tiene distribución \(\Phi_{\alpha}\) \(\Leftrightarrow\) \((-1/X)\) tiene distribución \(\Psi_{\alpha}\) \(\Leftrightarrow\) \(\log(X^{\alpha})\) tiene distribución \(\Lambda\).

Nota: en otros contextos de la Estadística (en particular en alguna rutinas del R), se le llama Weibull a una variable que corresponde a -X, con X Weibull como definimos nosotros.

Observación 5: Recordamos que la función Gamma (\(\Gamma\) ), que extiende a la función factorial (\(\Gamma(n)=n-1!\quad \forall n\) natural) definida por

\[\begin{equation} \Gamma(x)=\int_{0}^{\infty} t^{u-1}e^{-t}dt \end{equation}\]

es una función disponible tanto en el software R como en planillas de cálculo, etc.

Teorema 2: (Tres en uno) Algunos datos de las distribuciones extremales.

Parte 1

Si \(X\) tiene distribución \(\Lambda^{(\mu,\beta)}\) entonces tiene:

Esperanza: \(E(X) = \mu + \beta\gamma\), donde \(\gamma\) es la constante de Euler-Mascheroni, cuyo valor aproximado es \(0.5772156649\).

Moda: \(\text{moda}(X)=\mu\)

Mediana: \(\text{med}(X)=\mu - \beta \log(\log 2) \approx \mu - 0.36651 \beta\)

Desviación estándar: \(\sigma(X)=\frac{\beta \pi}{\sqrt{6}} \approx 1.2825 \beta\)

Si \(X^+ = \max(X,0)\), entonces \(E(X+k)\) es finito para todo valor de \(k\) natural

Para simular computacionalmente \(X\), se puede tomar \(U\) uniforme en \((0,1)\) y hacer \(X = \mu - \beta \log(-\log U)\).

Parte 2

Si \(X\) tiene distribución \(\Psi^{(\mu, \beta)}\) entonces tiene:

\(E(X)=\mu -\beta \Gamma (1+1/\alpha)\)

\[\begin{equation*}\text{moda}(X) =\begin{cases} \mu & \text{si }\; \alpha \leq 1 \\ \mu-\beta\left\{ \frac{\left( \alpha-1 \right)}{\alpha} \right\}^{1/\alpha} & \text{si }\; \alpha >1 \end{cases}\end{equation*}\]

\(\text{med}(X)=\mu - \beta (\log 2)^{\frac{1}{\alpha}}\)

\(\sigma(X)=\beta\left\{\Gamma\left( 1+\frac{2}{\alpha} \right)-\Gamma\left( 1+\frac{1}{\alpha} \right)^2 \right\}^{1/2}\).

Parte 3

Si \(X\) tiene distribución \(\Phi_{\alpha}^{(\mu, \beta)}\) entonces tiene:

\[\begin{equation*} E(x) = \begin{cases} \mu + \beta\;\Gamma\left( 1-\frac{1}{\alpha} \right) & \text{si } \alpha>1 \\ \infty & \text{en otro caso} \end{cases} \end{equation*}\]

\(\text{moda}(X)=\mu+ \beta\;\left\{ \frac{\alpha}{\left( 1+ \alpha\right)}\right\}^{1/\alpha}\)

\(\text{med}(X)=\mu + \beta \;\left( \log 2 \right)^{\left( -1/\alpha \right)}\)

\[\begin{equation*} \sigma(x) = \begin{cases} \mu + \left| \Gamma \left( 1 - \frac{2}{\alpha} \right) - \Gamma \left( 1 - \frac{1}{\alpha}\right)\right| & \text{si } \; \alpha>2 \\ \infty & \text{si } \; 1<\alpha \leq 2 \end{cases} \end{equation*}\]

Observación 6: El item e) de la Parte 1 es trivialmente cierto para Weibull y tomando en cuenta el item a) de la Parte 3, es claramente falso para Fréchet.

Observación 7: El item f) de la Parte 1 en conjunto con el Teorema 1 brinda fórmulas sencillas para simular computacionalmente distribuciones Weibull o Fréchet.

Observación 8: Se generaron mil números aleatorios y aplicando el item f) de la Parte 1: se simularon mil variables Gumbel standard \(iid\), calculándose su promedio, su desviación standard empírica y su mediana empírica.

# Fijar semilla para reproducibilidad

set.seed(123)

# Definir parámetros

mu <- 0 # Centro

beta <- 1 # Escala

gamma <- 0.5772156649 # Constante de Euler-Mascheroni

# Número de simulaciones

n <- 1000

# Generar 1000 valores de una variable uniforme en (0,1)

U <- runif(n)

# Simular la variable Gumbel con parámetros (mu, beta)

X_gumbel <- mu - beta * log(-log(U))

# Calcular estadísticas

esperanza <- mu + beta * gamma

moda <- mu

mediana_teorica <- mu - beta * log(log(2))

desviacion_std_teorica <- beta * pi / sqrt(6)

# Calcular estadísticas empíricas

promedio_empirico <- mean(X_gumbel)

desviacion_std_empirica <- sd(X_gumbel)

mediana_empirica <- median(X_gumbel)Los resultados fueron los siguientes:

## ----- Resultados teóricos: -----## Esperanza teórica: 0.5772157## Moda teórica: 0## Mediana teórica: 0.3665129## Desviación estándar teórica: 1.28255## ----- Resultados empíricos (simulación con n = 1000 ): -----## Promedio empírico: 0.5610296## Desviación estándar empírica: 1.261928## Mediana empírica: 0.3376409Observar que los resultados empíricos están cerca del valor esperado, desvío standard y mediana de la Gumbel standard.

A continuación presentaremos el Teorema medular de esta primera parte, expresado de la manera más llana posible. Veremos posteriormente algunos detalles con más cuidado. En particular, veremos que la continuidad de la distribución \(F\) no es una hipótesis real (ni es necesaria ni es suficiente, por eso la entrecomillamos), pero ayuda a visualizar que no vale el teorema para toda distribución \(F\), así como veremos con cierto detalle más adelante…

Teorema 3: de Fischer-Tippet-Gnedenko (FTG)

Si \(X_1,...,X_n\) es \(iid\) con distribución \(F\) ‘continua’, llamamos \(F^{\ast}_n\) a la distribución de \(max(X_1,...,X_n)\) y \(n\) es grande, entonces existen \(\mu\) real y \(\beta > 0\) tales que alguna de las siguientes tres afirmaciones es correcta:

- \(F^{\ast}_n\) se puede aproximar por la distribución de \(\mu+\beta Y\), con \(Y\) variable con distribución \(\Lambda\).

- Second item

- Third item